Nvidia har nu presenterat sin lösning på en chatbot men som kan köras lokalt och kräver inget internet, lösningen heter Chat with RTX.

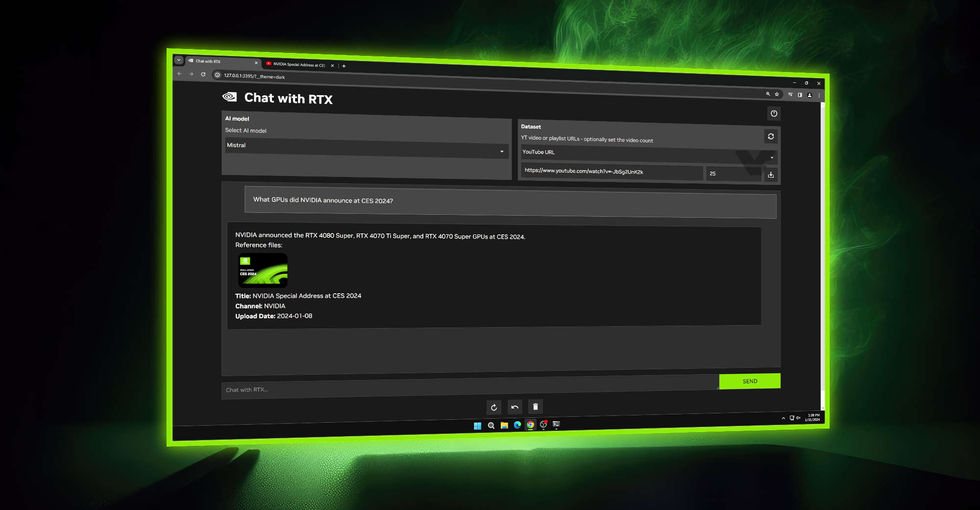

Nvidia som vet har sedan några år tillbaka satsat hårt med att utveckla AI-applikationer och fortsätter göra så. Nu har dom bland annat släppt en chatbot som dom kallar för Chat with RTX, en chatbot man kan installera på sin dator lokalt och i sin tur använda den direkt på datorn och inte på en hemsida.

Chat with RTX kommer att användas av Mistral och Llama 2 som är två stora och populära språkmodeller inom AI. Detta kommer göra det möjligt att bland annat kunna inkludera filer och dokument vilket gör att AI kan hämta ut läsa av dessa filer vid svar på våra frågor.

Är man sugen på testa Chat with RTX så är det gratis nu, dock finns det lite krav för att kunna köra denna chatbot AI, kräver bland annat att man har ett RTX 3000-serie eller RTX 4000-serie grafikkort för att kunna köra, ska även gå bra med RTX Ampere eller Ada-GPU med minst 8GB VRAM för att köra denna AI. Behöver även ha minst 16GB RAM och köra Windows 11.