Microsoft fortsätter att satsa stort på egen hårdvara för artificiell intelligens.

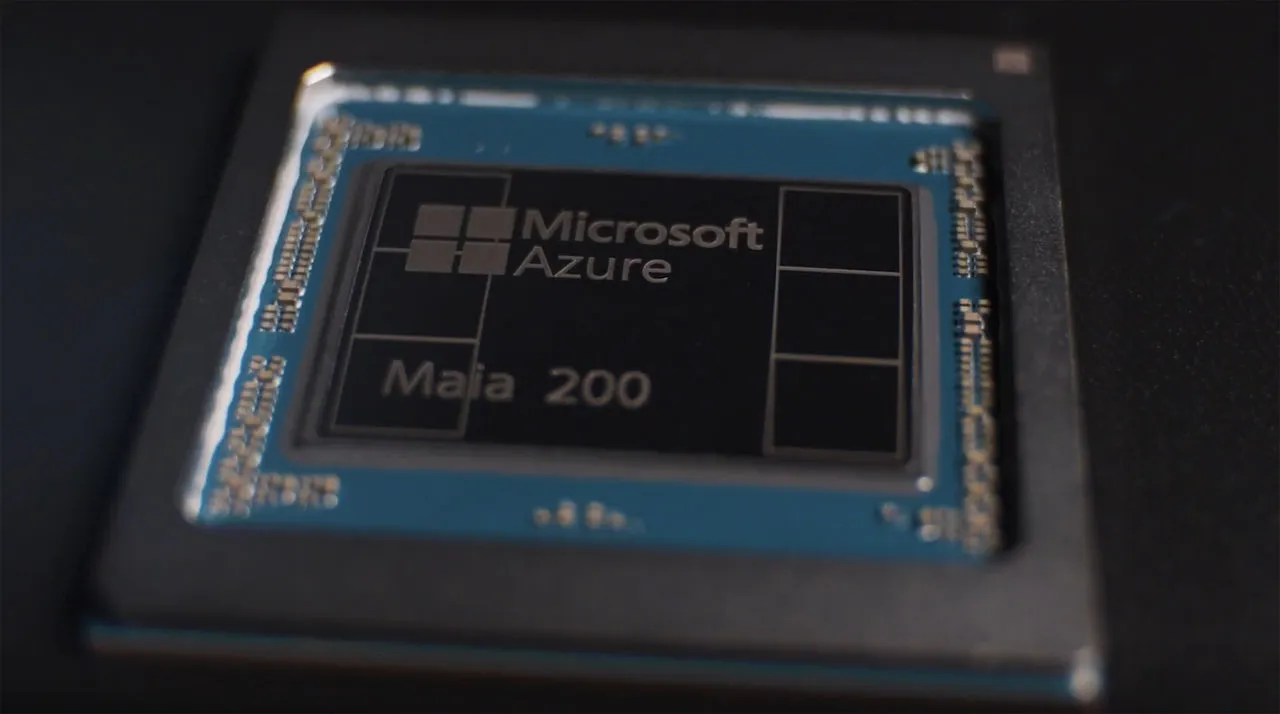

Efter det första Maia-chippet som presenterades 2023 har företaget nu visat upp Maia 200, en betydligt kraftfullare uppföljare som ska driva framtidens AI-tjänster i Azure.

Det här är inte ett chip som hamnar i vanliga datorer. Maia 200 är utvecklat exklusivt för Microsofts egna datacenter och är optimerat för att leverera snabba AI-svar snarare än att träna stora språkmodeller.

Fokus på AI-inferens snarare än träning

Till skillnad från många andra acceleratorer på marknaden är Maia 200 inte primärt byggt för att träna LLM:er. I stället är fokus lagt på inferens, alltså att snabbt och effektivt generera svar på användarnas promptar.

Enligt Microsoft är detta ett mer kostnads- och energieffektivt sätt att skala AI-tjänster i stor skala, särskilt för molnplattformar som Azure.

Avancerad tillverkning och enorm transistorbudget

Maia 200 tillverkas av TSMC med deras avancerade 3 nm-process, vilket placerar chipet i absoluta toppskiktet sett till modern halvledarteknik. Totalt rymmer kretsen omkring 140 miljarder transistorer, vilket möjliggör både hög prestanda och effektiv resursanvändning.

Prestanda i petaFLOPS och effektiv energianvändning

Microsoft uppger att Maia 200 kan leverera:

Beräkningskapacitet

- Över 10 petaFLOPS i FP4

- Cirka 5 petaFLOPS i FP8

Trots denna prestanda ligger effektförbrukningen på cirka 750 watt, vilket gör chipet relativt energieffektivt i förhållande till vad det presterar. För att hantera värmeutvecklingen används vattenkylning, något som blir allt vanligare i moderna AI-datacenter.

Snabbt minne och hög bandbredd

För att mata den höga beräkningskapaciteten är Maia 200 utrustat med generösa minnesresurser:

Minneskonfiguration

- 216 GB HBM3e-minne

- Upp till 7 TB/s minnesbandbredd

- 272 MB SRAM direkt på chipet

Denna kombination gör att stora datamängder kan hanteras snabbt, vilket är avgörande för AI-inferens i realtid.

Lägre kostnad än konkurrenterna

Enligt Microsoft ska Maia 200 vara upp till 30 procent billigare än jämförbara AI-chip från andra aktörer. Det ger Azure en tydlig fördel när det gäller att erbjuda konkurrenskraftiga AI-tjänster till företag och utvecklare.

Implementering i Azure-datacenter

Utrullningen av Maia 200 har redan påbörjats. De första installationerna sker i Microsofts datacenter i Des Moines, Iowa. När denna fas är klar planerar företaget att fortsätta expandera till fler datacenter globalt.

Hur står sig Maia 200 mot konkurrenterna?

Jämfört med andra specialiserade AI-acceleratorer som AWS Trainium3 och Google TPU v7 står sig Maia 200 väl, särskilt när det gäller minneskapacitet, bandbredd och kostnadseffektivitet. Microsofts strategi verkar tydligt inriktad på att optimera helheten i Azure snarare än att enbart jaga topprestanda på pappret.

Med Maia 200 tar Microsoft ett stort steg mot ökad kontroll över sin AI-infrastruktur. Kombinationen av hög inferensprestanda, effektiv energianvändning och lägre kostnad gör chipet till en central byggsten i framtidens Azure-plattform.

För Microsoft handlar det inte bara om rå kraft, utan om att leverera skalbar och hållbar AI till miljontals användare världen över.